Kombiniert man die Begriffe „Deep Learning“ und „Fake“ kommt „Deepfake“ heraus. So wird die Manipulation von Medieninhalten, wie Fotos, Videos und Audioaufnahmen, mit Hilfe künstlicher Intelligenz (KI) genannt. Deren Funktionsmechanismen sind dem menschlichen Gehirn mit seinen neuronalen Netzen nachempfunden. Mit einer entsprechenden, frei im Internet erhältlichen Software, kann so – zumindest theoretisch – jeder/jede zum Fälscher/zur Fälscherin werden.

Deepfake in der täglichen Praxis

Dass dies in der Praxis nicht ganz so einfach, insbesondere aber zeitintensiv ist, zeigt der Bericht von „reporter“ aus dem Medienangebot von „Funk“ (ARD und ZDF) vom 13.5.2020 (Dauer 11:34). Dabei ist die am häufigsten angewandte Art der Manipulation mittels Deepfake der sogenannte Face Swap. Hierzu wird das Gesicht von Person A durch das Gesicht von Person B ausgetauscht und mittels einer digitalen Maske überlagert.

In vereinfachter Form und – entgegen aufwändigeren Fälschungen – schnell als Manipulation zu erkennen, wird dieses Verfahren von zahlreichen Unterhaltungs-Apps genutzt. Dabei tauscht man die Gesichter vor der Kamera des Mobilgerätes oder setzt das eigene Gesicht auf die Körper von Prominenten und Cartoon-Figuren auf. In einer Art „Tauschgeschäft“ werden für eine kurzzeitige Unterhaltung persönliche Bilder und Videos auf oftmals im Ausland befindliche Server übertragen und diesen Diensten der Zugang zum persönlichen Bilderordner auf dem Smartphone gewährt. Kurz gesagt, erscheint dies mehr als fragwürdig, wenn es um den Schutz der Privatsphäre geht.

Existiert eine große Zahl, im Idealfall aus Blickwinkel und Aufnahmeort stark unterschiedlicher Fotos und Videos einer Person – wie bei Prominenten oft der Fall -, begünstigt dies die technisch machbare Qualität der Fälschung. Denn umso mehr Daten der KI zur Verfügung stehen, desto besser kann diese die Augen- und Mundbewegungen einer Person in verschiedenen Situationen „erlernen“, um sie in weiteren Schritten nachzuahmen. Dass es nur eine Frage der Zeit ist, bis auch einige wenige Fotos für täuschende Fälschungen ausreichen, davon geht Prof. Dr. Martin Steinebach vom Fraunhofer-Institut für Sichere Informationstechnologie im obigen „reporter“ Bericht aus.

Deepfakes von bekannten Persönlichkeiten

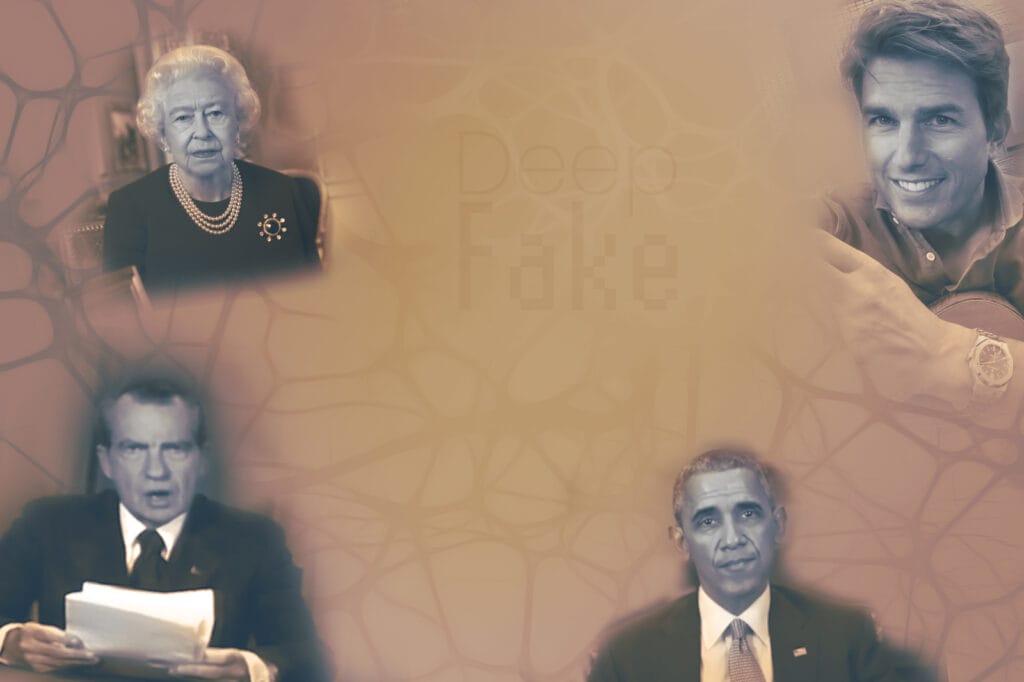

Ein berühmtes „Opfer“ von Deepfakes ist Barack Obama, der verkörpert durch den Schauspieler Jordan Peele seinen Nachfolger Donald Trump beleidigte. Auch beider Amtsvorgänger Richard Nixon wurde schon Protagonist eines Deepfakes, das ihn beim Verlesen einer für den Fall des Scheiterns der Mondlandung verfassten Rede an die Nation zeigt. Selbst die Queen in ihrem Buckingham Palast blieb durch die von dem Privatsender Channel 4 inszenierte alternative Weihnachtsansprache 2020 nicht davon verschont. Auch Schauspieler Tom Cruise wurde unfreiwillig auf der beim jungen Publikum beliebten Social Media Plattform „tiktok“ unter dem Namen „deeptomcruise“ gefälscht.

Weit zurück in die Vergangenheit geht der Ahnenforschungsanbieter „My Heritage“, wie DerStandard vom 28.2.2021 berichtet. Mittels „Deep Nostalgia“ werden dort aus Fotos bewegte Bilder und Verstorbene – aber auch nur diese – zum Lächeln gebracht. So unter vielen anderen die amerikanische Dichterin Emily Dickinson.

Gefahren durch Mißbrauch

„Videos, die mit Hilfe künstlicher Intelligenz manipuliert wurden, wirken immer echter.“ Schreibt DerStandard vom 12.7.2020 und fragt weiter: „Wie gefährlich sind Deep Fakes für die Demokratie?“

Täuschend echte, sich in den sozialen Medien rasend schnell verbreitende Fälschungen, besitzen enormen gesellschaftlichen, wirtschaftlichen und politischen Zündstoff. Mit anderen Worten, sie können einzelne Existenzen zerstören. Ähnlich wie die durch die Ära Trump geprägten „Fake News“ in Textform, können sie zur Meinungsmanipulation eingesetzt werden. Im schlimmsten Fall auch kriegerische Auseinandersetzungen durch gefälschte Marschbefehle und Beleidigungen von Staatsoberhäuptern heraufbeschwören. Auch die Manipulation von Satellitenbildern ist ein mögliches Szenario, wie DerStandard am 29.4.2021 berichtet. Dies schüre Zweifel an deren Authentizität.

Der größte Missbrauch der Technologie findet in Form der Verbreitung von gefälschten Nacktaufnahmen im Internet statt. Darüber beklagt sich ein Opfer in der ausführlichen Dokumentation (Dauer 30:33) zum Thema „Deepfake“ des ZDF in „Leschs Kosmos“. Auch die Konrad-Adenauer-Stiftung hat sich mit der Thematik Deepfakes im Februar 2020 befasst. Ihre „Analysen & Argumente, Digitale Gesellschaft – Nr. 382“ können hier als pdf abgerufen werden.

Erkennen von und Schutz vor Deepfakes

Erkennen von Fälschungen

Es sind die kleinen Details – wie Verzerrungen der Augenpartie, der leichte Hall der Stimme, das zu hektische Blinzeln sowie Artefaktbildungen an Kanten bei Bewegungen -, die uns zeigen, dass an den Aufnahmen etwas nicht stimmt. Oft reicht schon die Betrachtung auf einem hochauflösenden Monitor, um entgegen dem Smartphone-Display den Schwindel auffliegen zu lassen.

Auf gleiche Weise wie sie erstellt werden, sind Deepfakes mithilfe von Software auch zu enttarnen. Diese erkennt subtile Überblendungen und Bildinformationen wie Graustufenelemente, die für das bloße Auge nicht wahrnehmbar sind. Hieraus berechnet die Software, einen „Vertrauenswert“, gleichbedeutend einer prozentuellen Wahrscheinlichkeit, ob eine Fälschung vorliegt. Dieser wird simultan zum untersuchten Video/Bild eingeblendet. Die entsprechende Software hat Microsoft unter dem Namen „Video Authenticator“ entwickelt, wie Heise online am 2.9.2020 vermeldet.

Schutz vor Fälschungen

Bereits entwickelt sind Filter, die Bilderinformationen für das menschliche Auge unsichtbar auf Pixelebene verändern. Von solch einem Projekt der Universität von Toronto/Kanada berichtet die österreichische Computerwelt vom 4.6.2018. Derart veränderte Bilder sind nicht mehr zu manipulieren.

Aber der einfachste Schutz für Privatpersonen ist der spar- und sorgsame Umgang mit Fotos und Videoaufnahmen in sozialen Medien, wie Facebook oder Instagram. Außerdem können Profile auf „privat“ geschalten werden, sodass nur Freunde und Bekannte Zugriff haben.

Aktualisierung

Der Verlag für Rechtsjournalismus in Berlin hat auf seinem Ratgeberportal „ANWALT.ORG“ am 31.8.2023 die mit dem gegenwärtigen KI-Boom einhergehenden Neuerungen eingefangen. Dabei wird der Austausch von Gesichtern (face swapping), Stimmen (voice swapping) sowie einzelner Bewegungen oder ganzer Bewegungsabläufe (body puppetry) unterschieden. Natürlich werden auch die juristischen Folgen von Deepfakes kompetent beleuchtet.

Und hier wird es wieder spitzfindig – einigermaaßen baerig ebenfalls.

#PreppoKompakt

Aufgrund des technischen Fortschritts in Form der KI können wir immer weniger unseren Sinnen trauen. Beschränkte sich dies bei Einführung der Software „Photoshop“ auf Bilder, sind nun auch Video- und Audiosequenzen davon betroffen. Während dies in der Unterhaltungsindustrie – in Filmen und Computerspielen – für immer realistischere Szenarien sorgt, kann es im wahren Leben schnell zum Alptraum werden. Folglich sind, wie bei anderen Technologien auch, Staat und Gesellschaft gefordert, bei den Bürgerinnen und Bürgern ein gesundes Bewußtsein für die Manipulierbarkeit von Medieninhalten zu entwickeln.